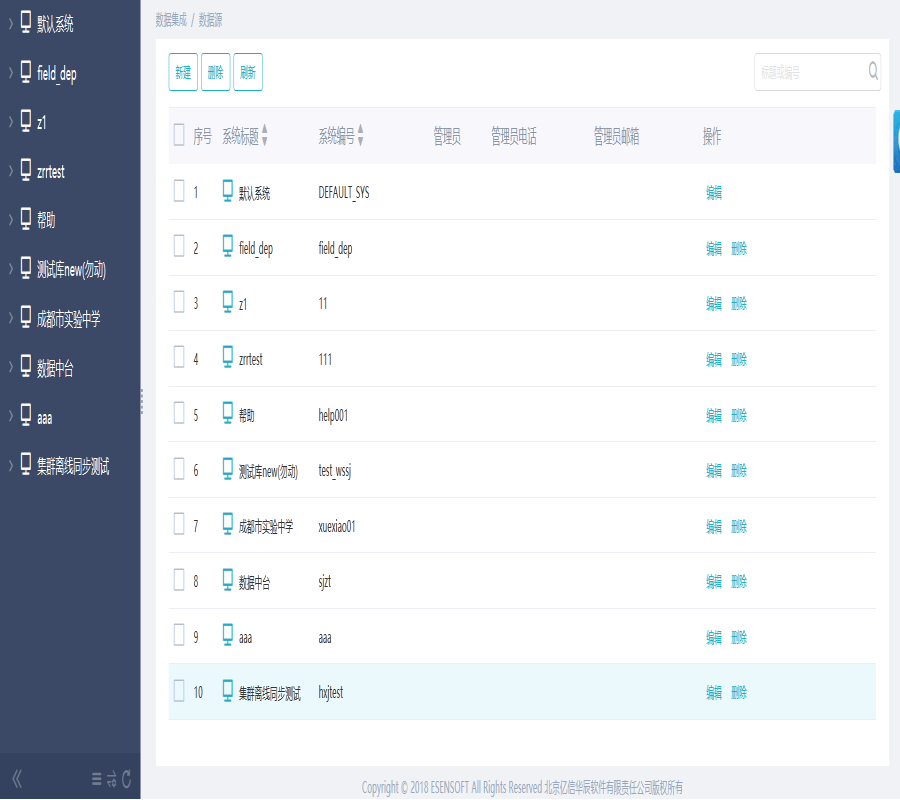

在数据源中可以新建系统,系统中包含所有类型的数据源。系统初始化时会自动创建一个默认系统。

1.新建系统节点

在数据集成下数据源中可以新建系统,主要是对产品的业务系统进行管理,实现不同系统间的数据传输

新建系统,如下图

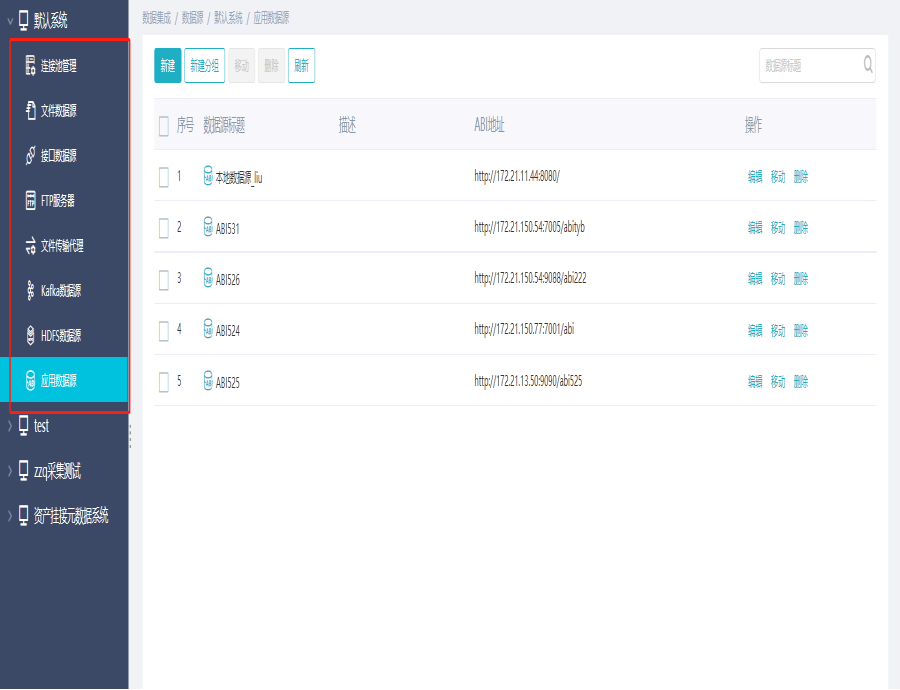

每个系统下面有8个节点,分别为数据库连接池、文件数据源、接口数据源、FTP服务器、文件传输代理、Kafka数据源、HDFS数据源以及应用数据源

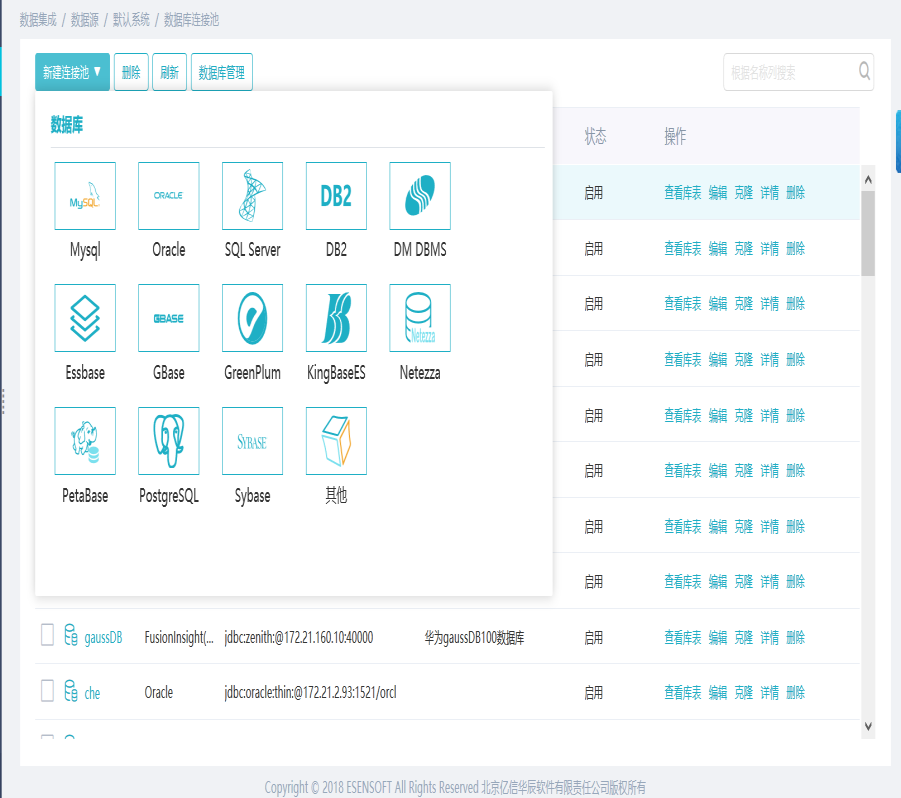

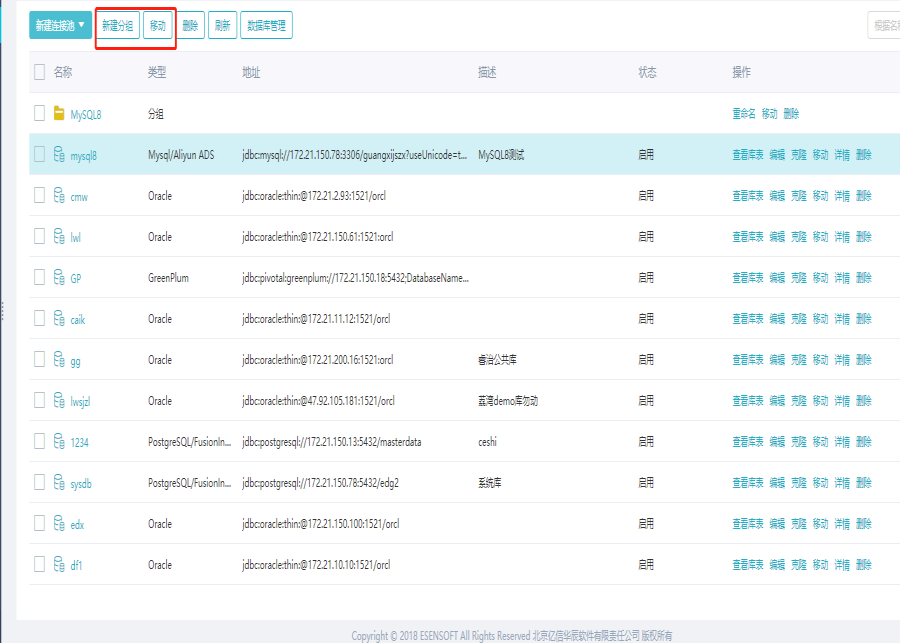

2.数据库连接池

2.1新建连接池

点击”新建连接池”按钮,界面会出现多种类型的数据库连接池可供选择,包括Mysql、Oracle、SQL Server、DB2等,如下图

以Oracle数据库为例,新建一个连接池,如下图所示

若以上提供的数据库类型没有满足需求的,可以新建其他类型的数据库,同时可以对数据库连接池进行分组移动操作。

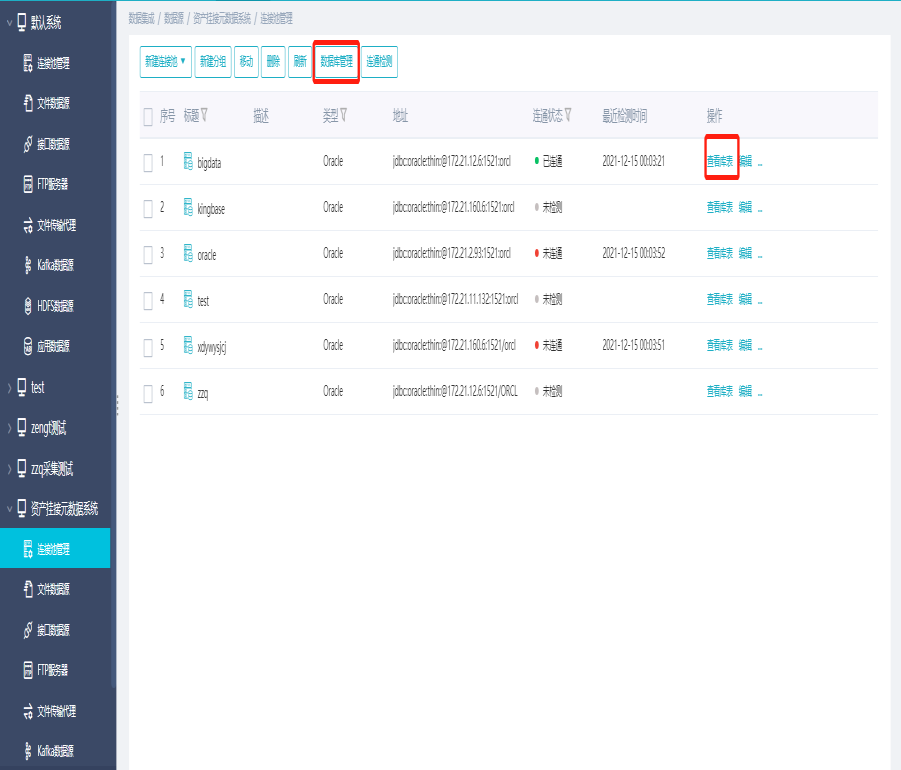

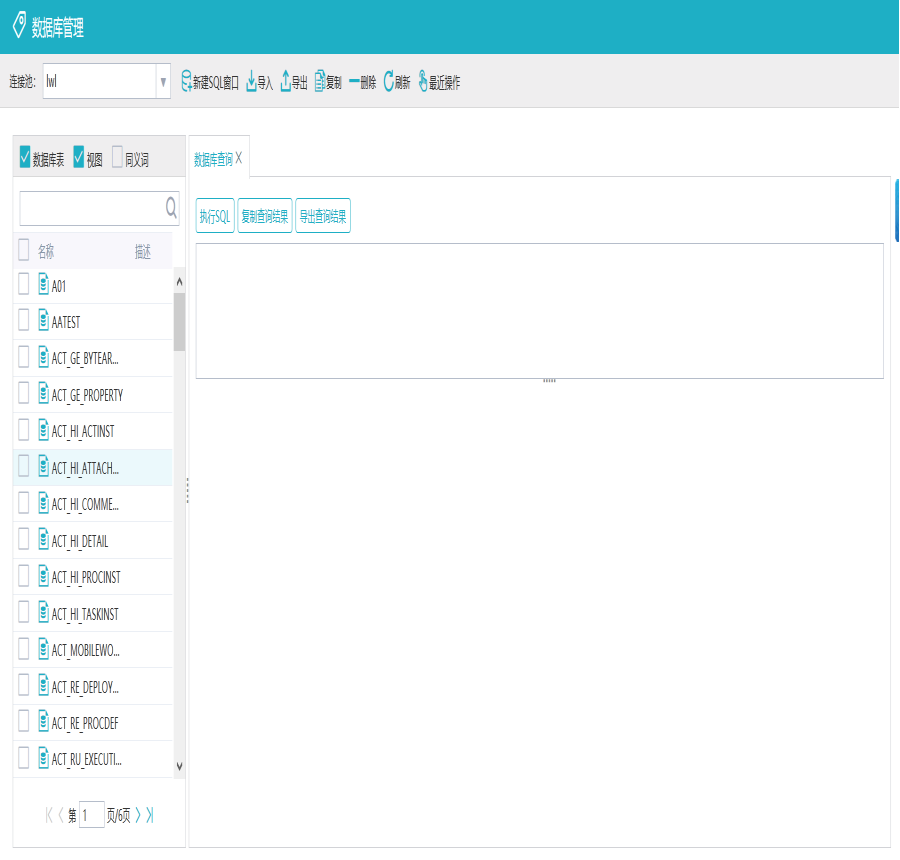

2.2数据库管理

点击某一数据库连接池的”查看库表”或者是点击界面上方的”数据库管理”按钮都可以进入数据库管理页面

数据库管理界面具有如下功能:模糊查询,执行sql,导入导出数据库表,复制数据库表,删除数据库表,或者查看当前服务器对数据库表做的操作

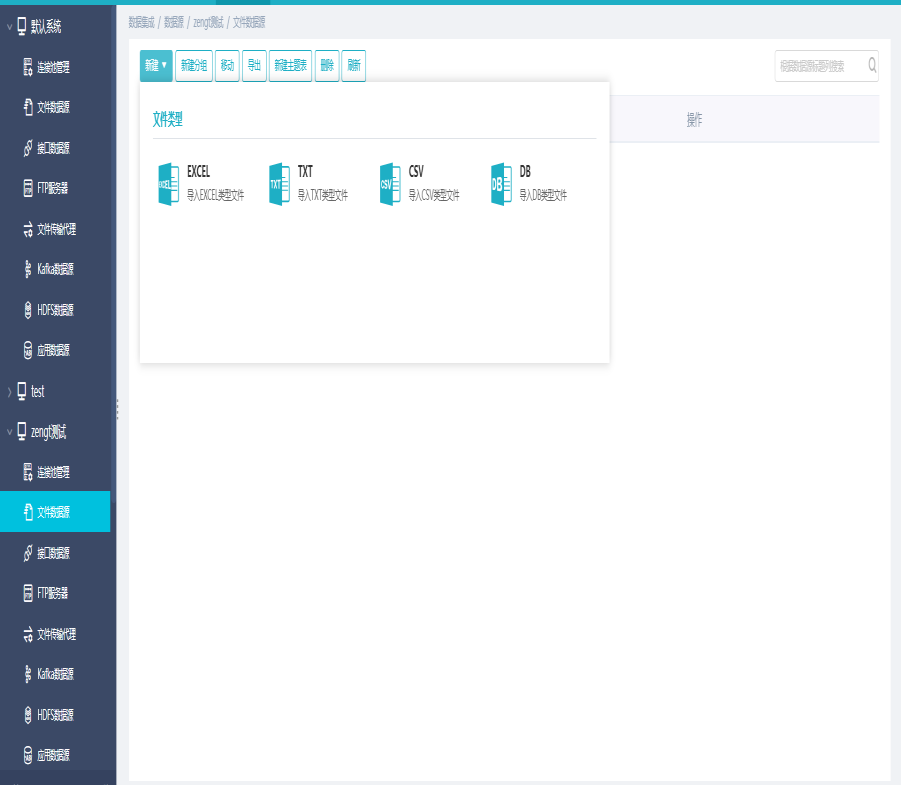

3.文件数据源

文件数据源可以将本地文件上传到服务器,可以用来新建主题表,以及在平面文件输入组件和Excel输入组件中使用,如下图

文件数据源有4种文件类型,分别为EXCEL、TXT、CSV、DB

文件数据源列表下可新建分组,在分组下可新建数据源,数据源支持移动分组。

4.文件传输代理

文件传输代理用于不同系统间文件的传输,通过两个mq节点来实现文件传输

4.1配置代理节点

4.1.1window操作系统配置

1)安装代理

解压客户端安装包edataexchange-mq.zip即可。

2)配置环境

修改传输代理的内存大小、端口号、工作路径、JDK路径等在启动文件run.bat中设置。

配置参考如下:

set JAVA_OPTS=-Xmx1024M -Dserver.port=8686 -Desen.edx.mq.port=61616 -Desen.edx.workdir=%~dp0/workdir/

%~dp0\jdk1.7.0_21\bin\java %JAVA_OPTS% -jar edataexchange-mq-1.1.2-SNAPSHOT.jar

注:其中内存大小不能低于1024M,8686是jar包内置tomcat的端口,61616是TCP监听端口

3)启动传输代理

点击run.bat运行即可。

提示如下表示启动成功:

2017-06-18 14:16:45.775 INFO 8752 --- [ main] s.b.c.e.t.TomcatEmbeddedServletContainer : Tomcat started on port(s): 8686 (http) 2017-06-18 14:16:45.781 INFO 8752 --- [ main] c.esen.edataexchange.mq.RestartService : ApplicationReadyEvent : 2017-06-18 14:16:45.782 INFO 8752 --- [ main] c.e.edataexchange.mq.EdxMQApplication : Started EdxMQApplication in 8.555 seconds (JVM running for 9.16) |

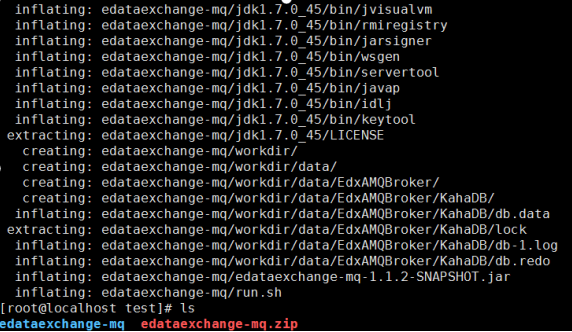

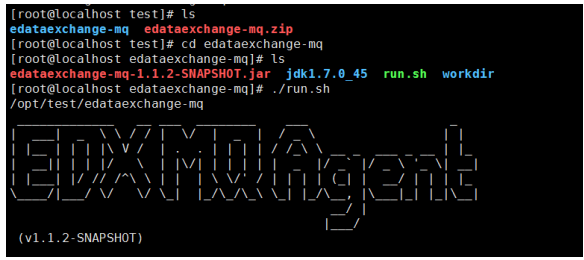

4.1.2Linux操作系统

1)安装代理

将客户端安装包edataexchange-mq.zip上传至linux服务器,如 /opt/test下,解压安装包

解压命令:unzip edataexchange-mq.zip

2)配置环境

修改传输代理的JDK路径、内存大小、端口号、工作路径等在启动文件

run.sh中设置。

配置参考如下:

$Cur_Dir/jdk1.7.0_45/bin/java -Xmx1024M -Dserver.port=8686 -Desen.edx.mq.port=61616 -Desen.edx.workdir=$Cur_Dir/workdir/ -jar edataexchange-mq-1.1.2-SNAPSHOT.jar

注:$Cur_Dir指获取当前路径,内存大小不能低于1024M ,8686是jar包内置tomcat的端口,61616是TCP监听端口

3)启动传输代理

进入解压后的文件夹即可运行,命令如下:

cd edataexchange-mq

./run.sh

如下表示启动成功:

2017-06-18 14:23:09.805 INFO 1752 --- [ main] s.b.c.e.t.TomcatEmbeddedServletContainer : Tomcat started on port(s): 8686 (http) 2017-06-18 14:23:09.805 INFO 1752 --- [ main] c.esen.edataexchange.mq.RestartService : ApplicationReadyEvent : 2017-06-18 14:23:09.805 INFO 1752 --- [ main] c.e.edataexchange.mq.EdxMQApplication : Started EdxMQApplication in 8.309 seconds (JVM running for 8.912) |

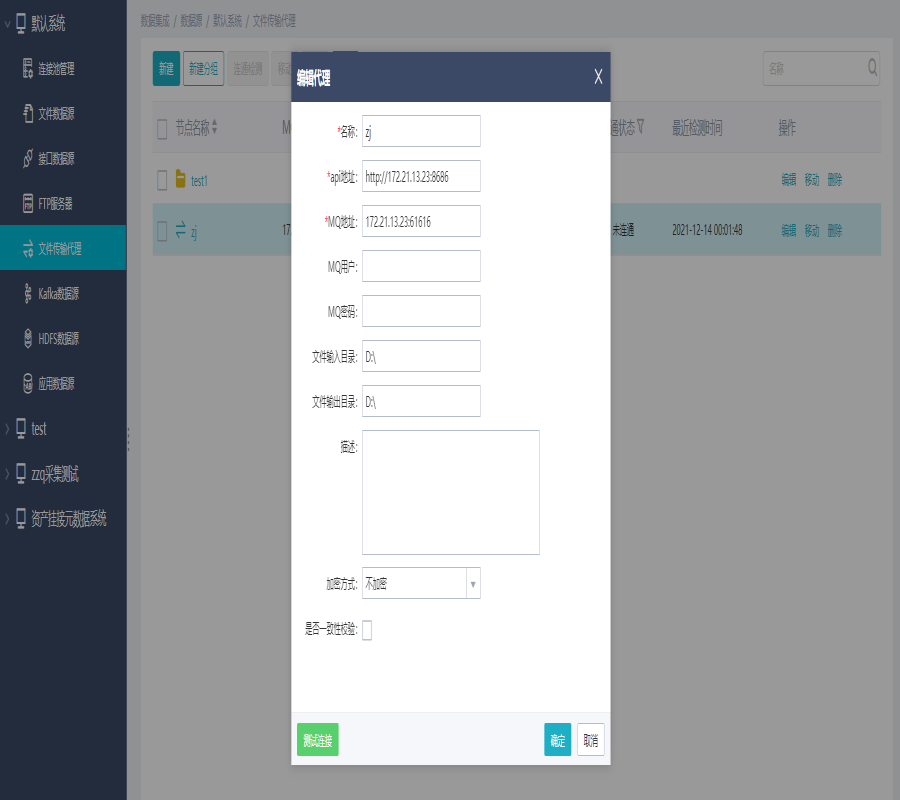

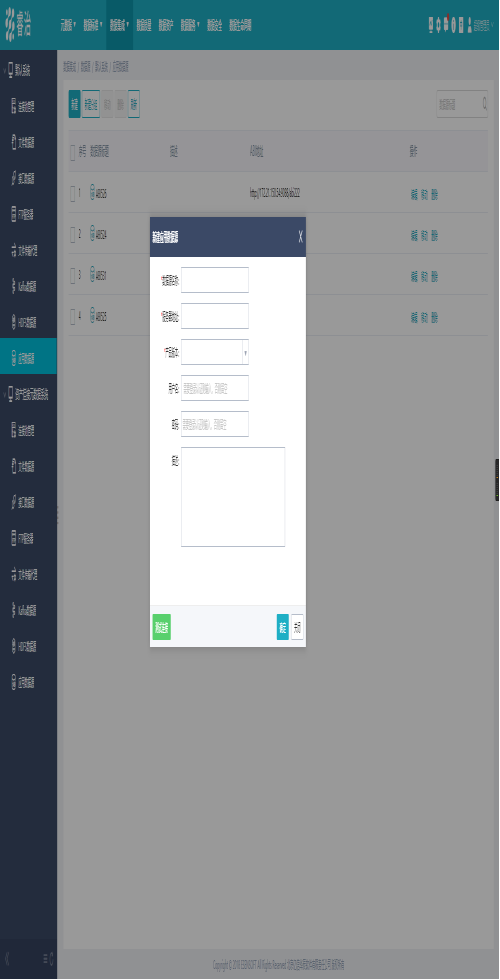

4.2添加文件传输代理

输入代理的名称、api地址、MQ地址、MQ用户、MQ密码、输入目录输出目录和描述,设置加密方式,用户可根据实际需求来勾选一致性校验。

设置完成后,可以点击"测试连接"进行连接测试,若连接失败,可根据出错信息进行参数的调整;若连接成功,点击"确定"即可完成数据库连接池的新建

设置如下图所示:

api地址端口号默认8686,MQ地址端口号默认61616

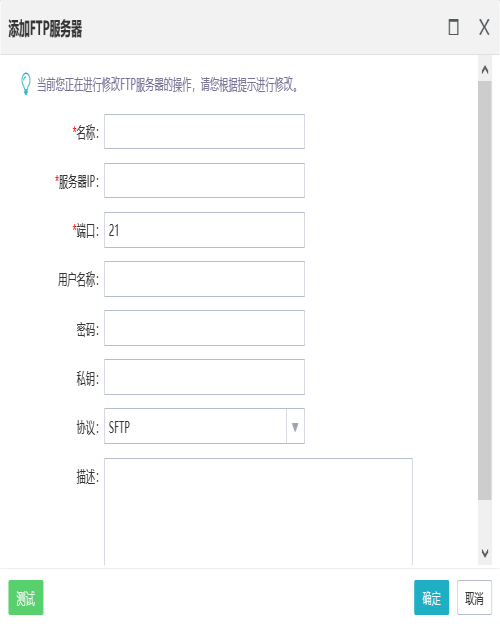

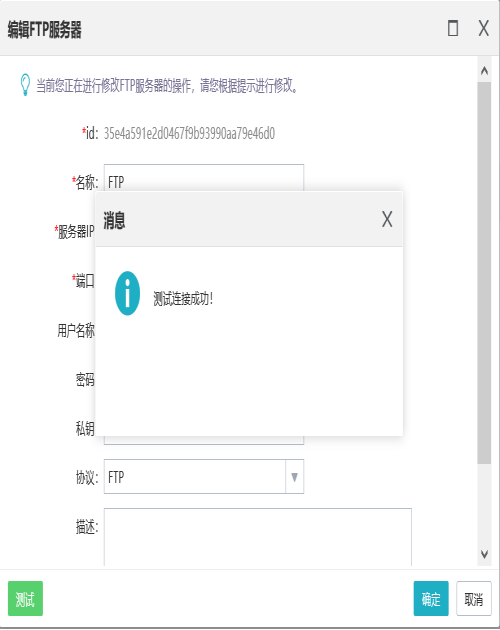

5.FTP服务器

当需要与服务器进行FTP连接时,可以使用FTP服务器。

点击新建添加FTP服务器

点击测试,可以测试是否连接成功

6.接口数据源

当需要与第三方系统传输过来的接口数据进行数据传输时,需要使用接口数据源。

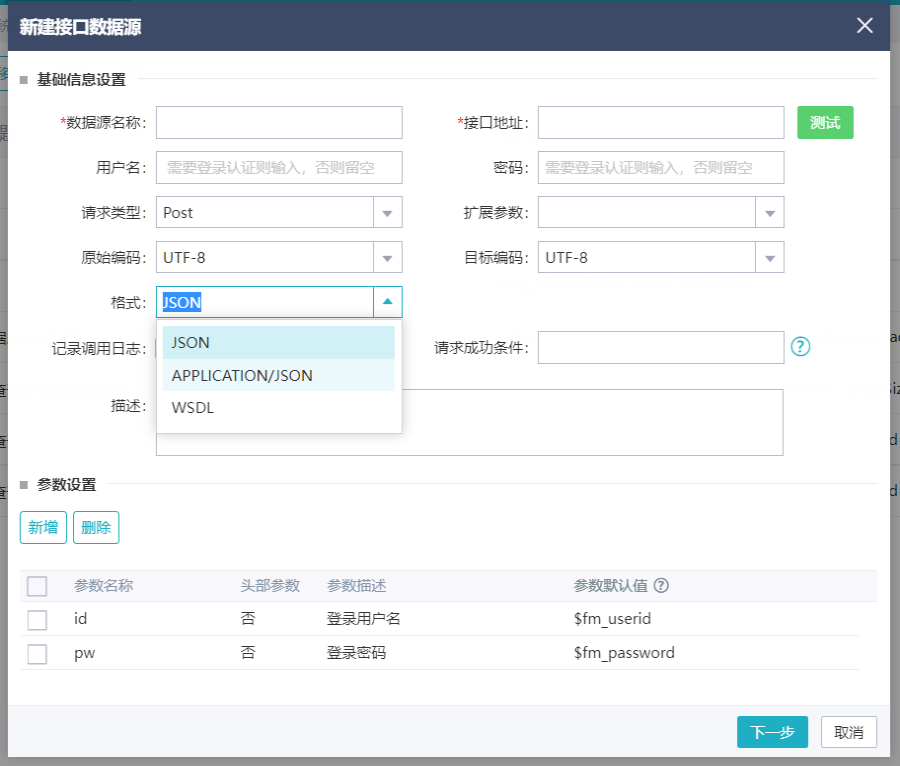

目前接口数据源支持JSON格式,APPLICATION/JSON和WSDL格式

示例如下图,接口地址:https://www.apiopen.top/weatherApi

点击测试可以看到获取的数据

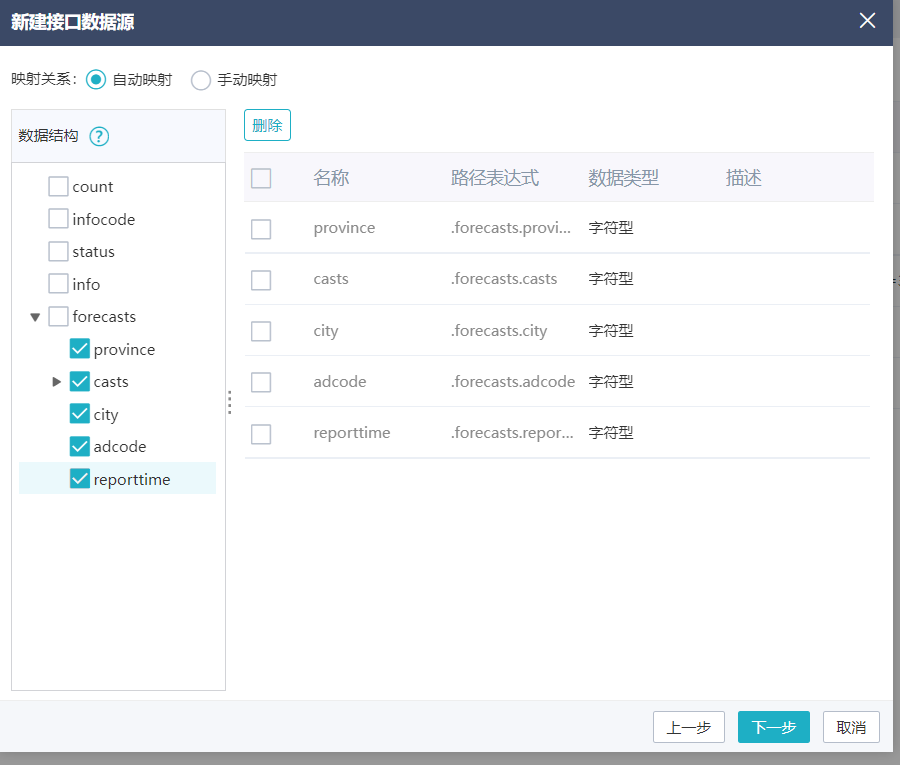

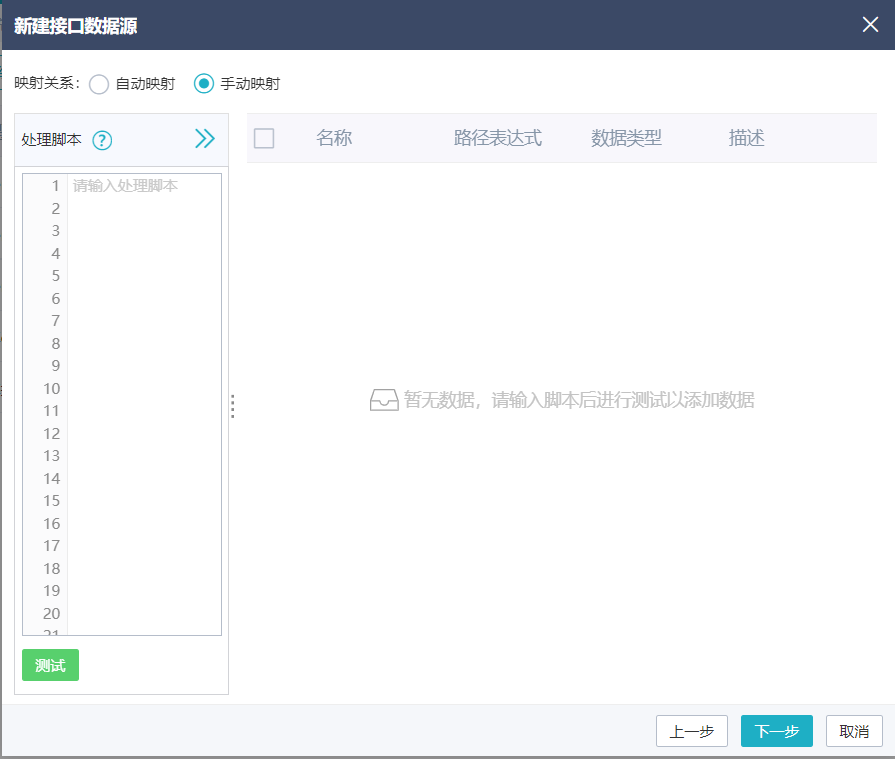

点击下一步,进去字段映射界面,当为JSON格式时,可通过自动映射或手动映射选择字段,完成之后确定保存

7.按HDFS地址创建数据源

本小节主要介绍了用户需要对接大数据平台时如何按照HDFS地址创建数据源。

7.1前提条件

用户已部署HDFS服务器。

7.2应用场景

用户在产品中要对接大数据平台,对接HDFS,此时可创建HDFS服务器,用户填写好相关配置信息进行连接。在任务设计过程中在大数据组件选择该数据源进行使用。

通过数据源配置HDFS服务器,从而可以连接到Hadoop集群,实现对HDFS的读写。

7.3操作步骤

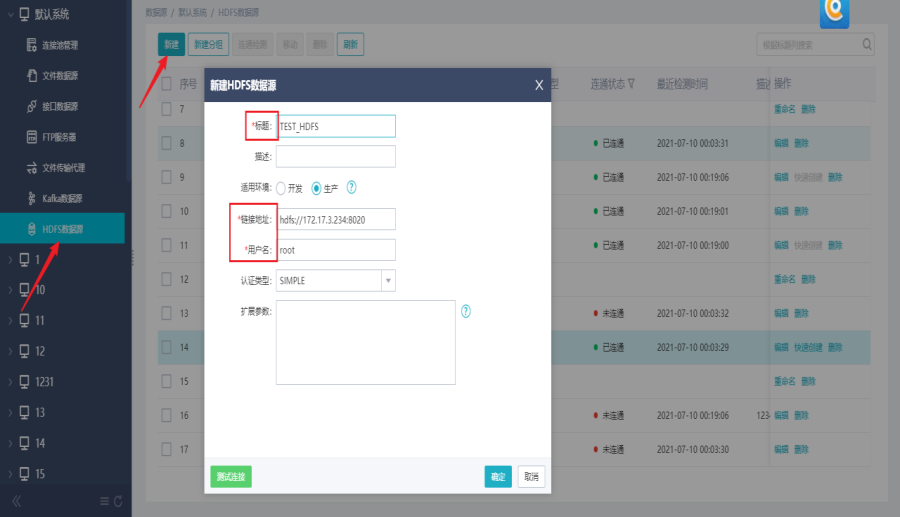

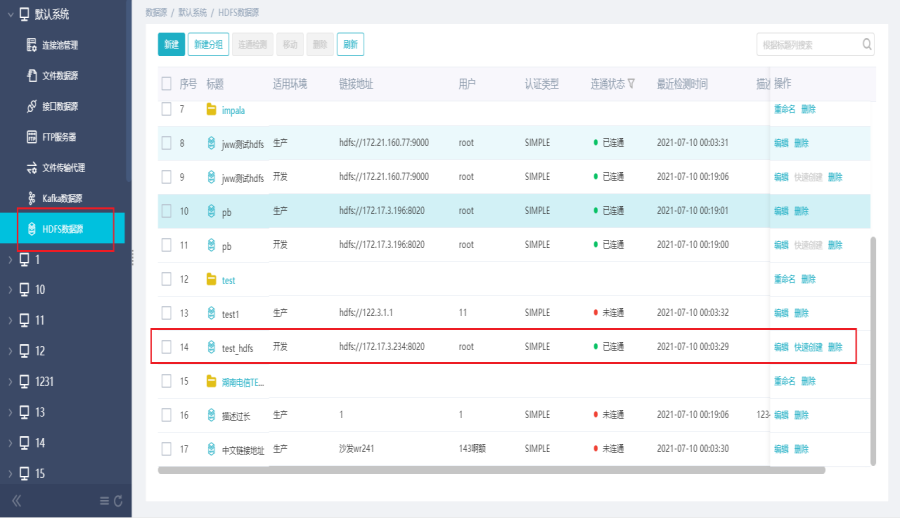

操作入口:【数据源>系统>HDFS数据源】

1)新建数据源

用户在系统下选择HDFS数据源,可新建分组,在分组下点击新建,填写标题、链接地址、用户名、选择开发/生产等信息。

2)连接测试

用户可点击连接测试,测试成功后点击保存。可在列表中查看创建信息。

注:连接测试成功的数据源在列表信息中显示“已接通”,未测试或测试不通过的数据源在列表中显示“未接通”

3)编辑HDFS数据源

点击编辑,可对数据源进行编辑操作,编辑后点击确定保存。可对文件夹进行重命名。

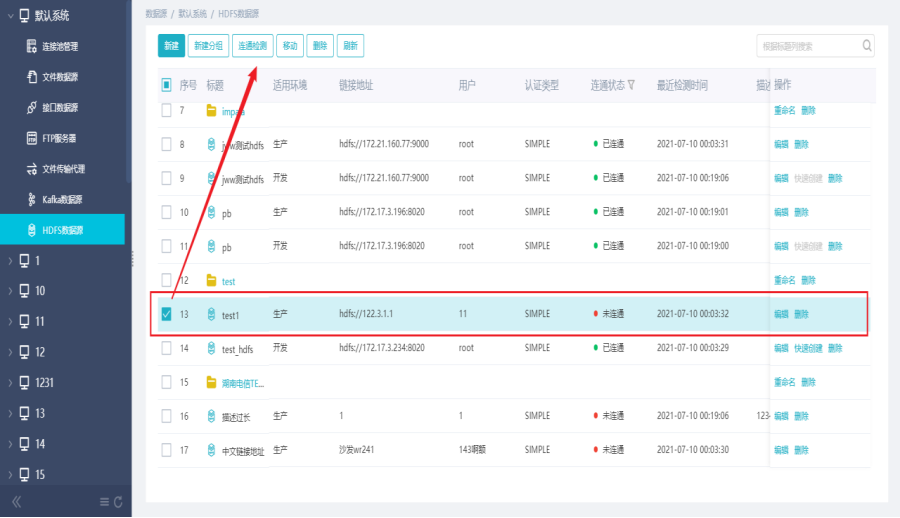

4)连通检测

用户选择某一“未接通”数据源,点击连通检测,可对数据源进行检测操作。

5)移动数据源

用户选择某一数据源,点击移动,可对数据源进行移动操作。

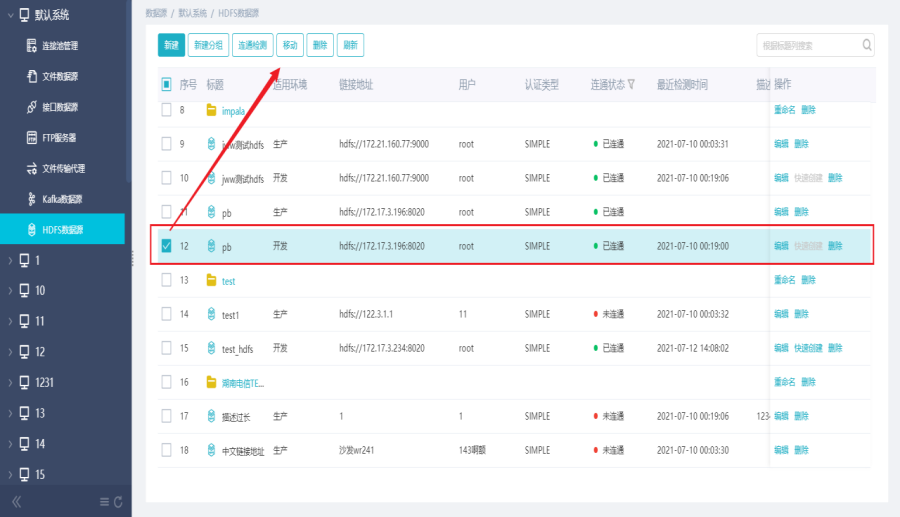

6)快速创建HDFS数据源

用户可对适用环境为“开发”的数据源进行快速创建操作。

注:快速创建仅支持创建一次。通过快速创建而新建的数据源不具备快速创建功能。

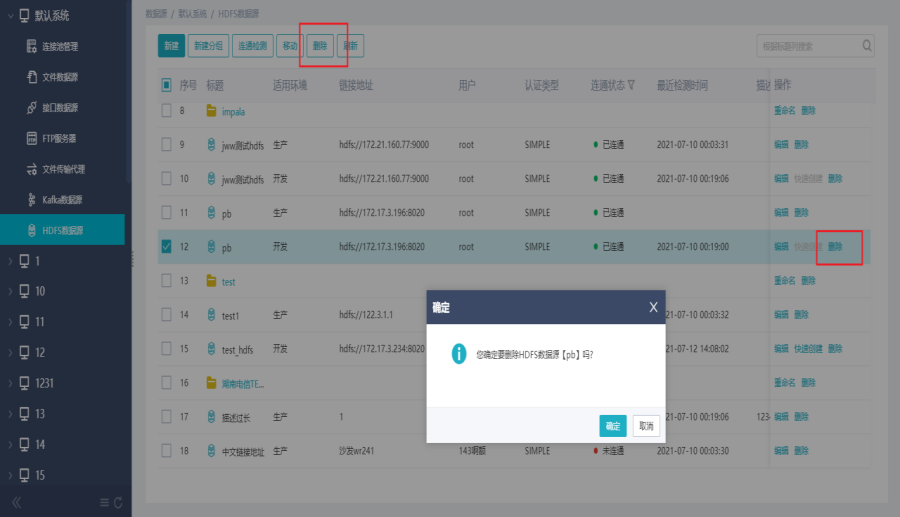

7)删除HDFS数据源

用户勾选某一个或多个数据源,点击删除,可对数据源进行删除和批量删除操作。

8.按Kafka地址创建数据源

本小节主要介绍了用户需要对接Kafka数据源时,如何创建Kafka服务器,从而能够从Kafka消费消息。

8.1前提条件

用户已部署Kafka服务器。

8.2应用场景

用户在产品中对接Kafka数据源,创建Kafka服务器,填写好相关配置信息进行连接测试。在任务设计时,可以选择配置好的Kafka服务器,将消息写入Kafka,或者从Kafka消费消息。

kafka数据源,可配置broker(IP和端口如192.168.1.1:9092)、zookeeper,后续相关组件可默认使用该配置,不在需要单独设置。

8.3操作步骤

操作入口:【数据源>系统>Kafka数据源】

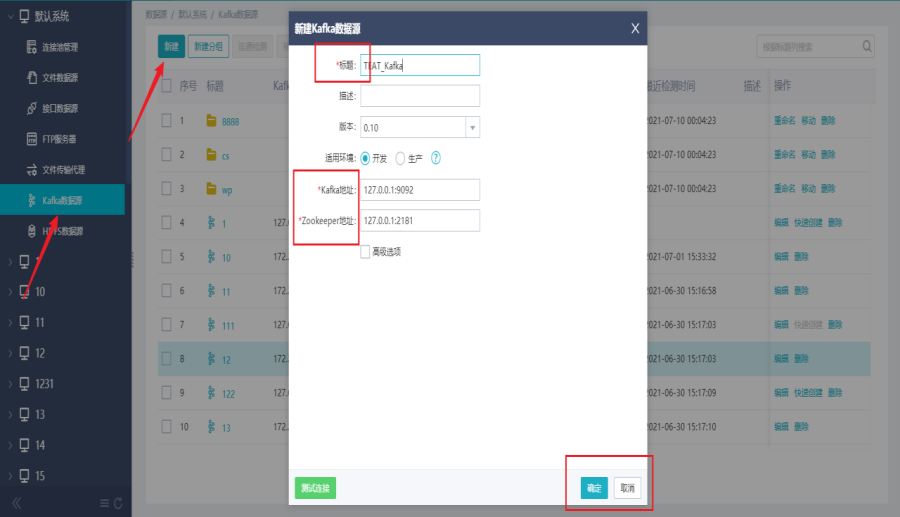

1)新建数据源

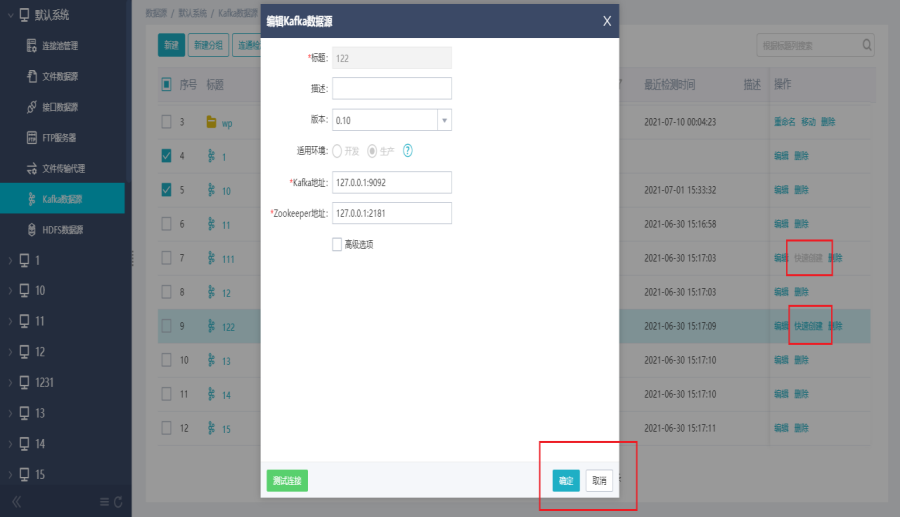

用户在系统下选择Kafka数据源,可新建分组,在分组下点击新建,填写标题、链接地址、用户名、选择开发/生产等信息。

2)连接测试

用户可点击连接测试,测试成功后点击保存。可在列表中查看创建信息。

注:连接测试成功的数据源在列表信息中显示“已接通”,未测试或测试不通过的数据源在列表中显示“未接通”

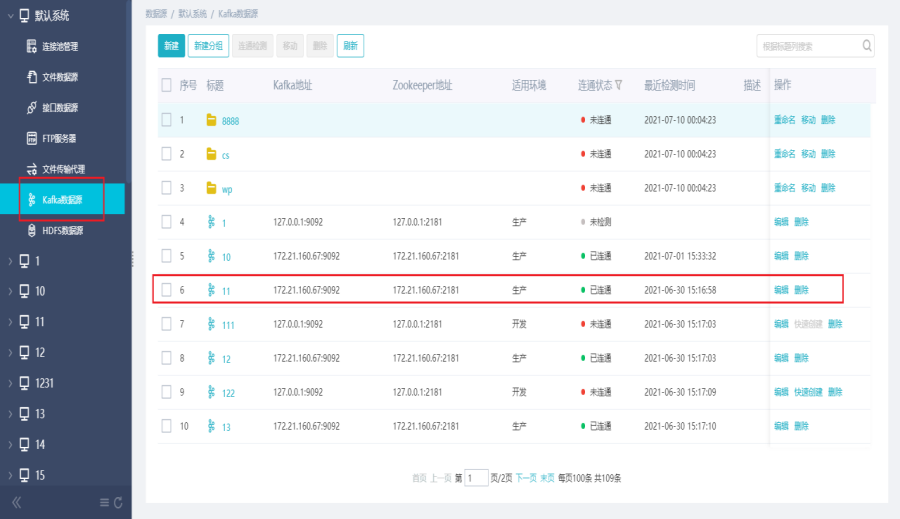

3)编辑Kafka数据源

点击编辑,可对数据源进行编辑操作,编辑后点击确定保存。可对文件夹进行重命名。

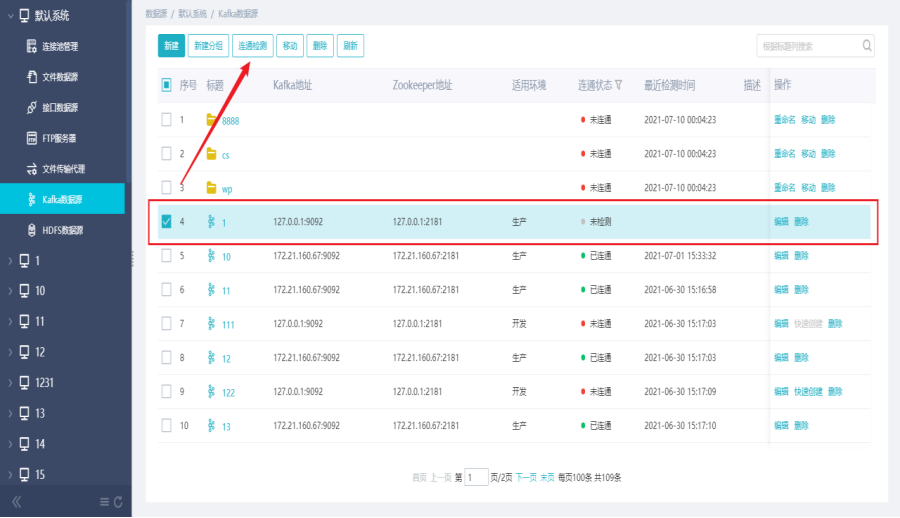

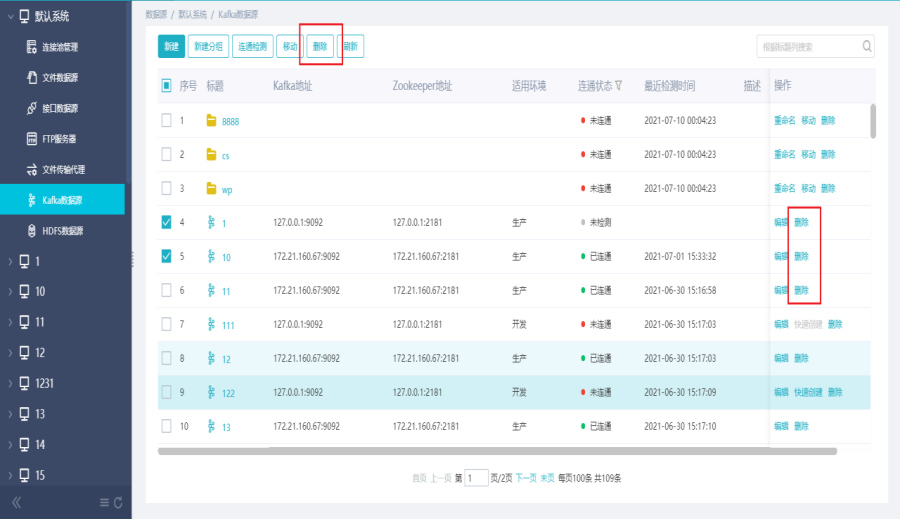

4)连通检测

用户选择某一“未接通”数据源,点击连通检测,可对数据源进行检测操作。

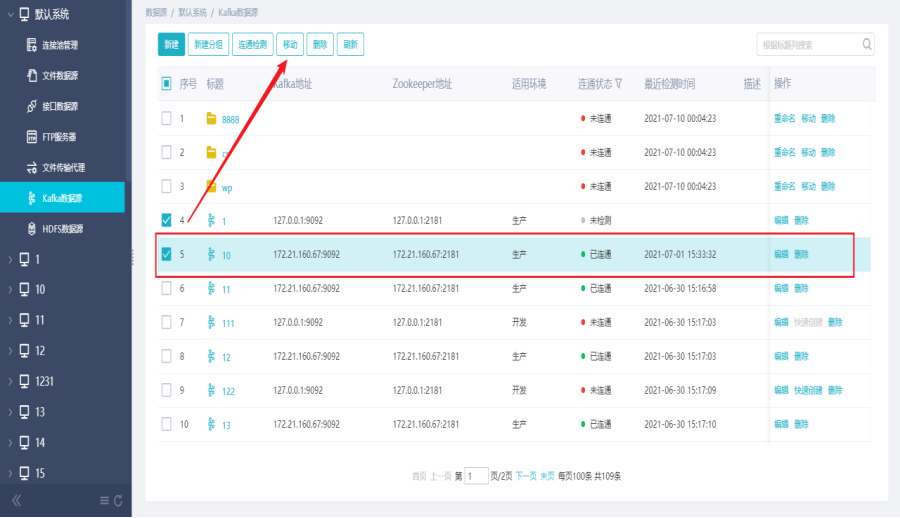

5)移动数据源

用户选择某一数据源,点击移动,可对数据源进行移动操作。

6)快速创建Kafka数据源

用户可对适用环境为“开发”的数据源进行快速创建操作。

注:快速创建仅支持创建一次。通过快速创建而新建的数据源不具备快速创建功能。

7)删除Kafka数据源

用户勾选某一个或多个数据源,点击删除,可对数据源进行删除和批量删除操作。

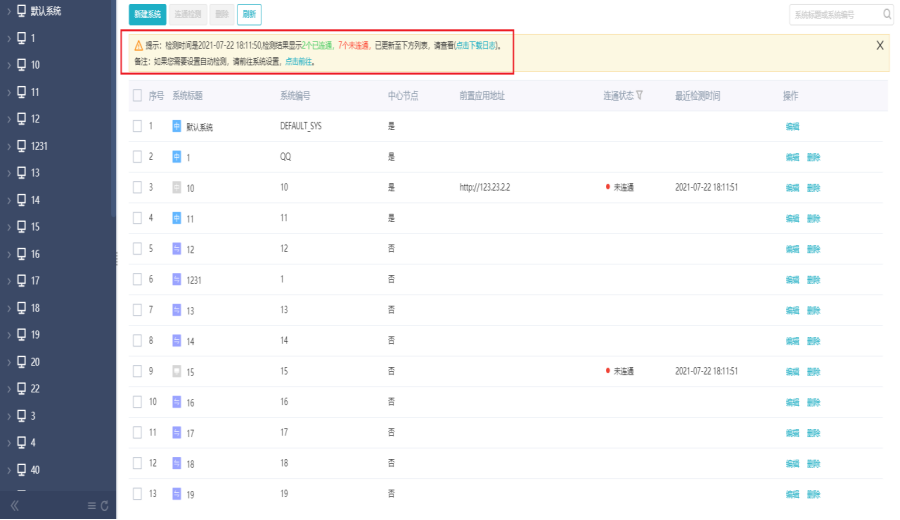

9.数据源批量检测是否连通

本小节主要介绍了用户如何通过批量检测或设置定时检测直接在数据源处清楚的看到哪些连接池处于未检测或未接通状态。

9.1前提条件

用户已新建数据库连接池、MQ文件传输代理、FTP服务器、HDFS、Kafka数据源。

9.2应用场景

管理员将各部门开放出来的各类数据库连接池维护到平台中,做了一些数据交换,过了一段时间后,有些部门的数据库被停掉了,管理员登录到平台后,能够直接在数据源处清楚的看到哪些连接池无法连接且处于不可用的状态,同时还能够手动去批量检测数据源的连接状态。

9.3操作步骤

操作入口:【数据源>系统>数据源>连通检测】

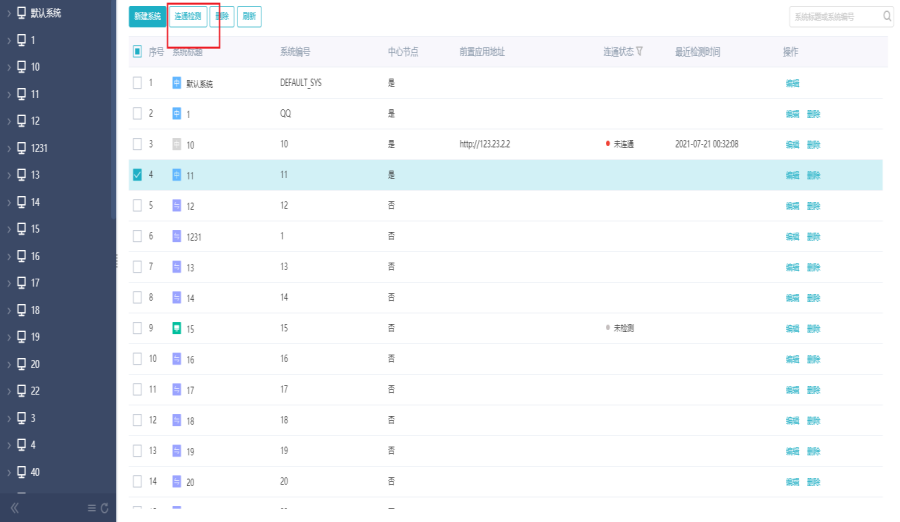

1)连通状态列表

用户点击进入“连接池管理”、“文件传输代理”、“FTP服务器”、“HDFS数据源”、“Kafka数据源”界面,可以看到连通状态(未连通/已连通/未检测)。

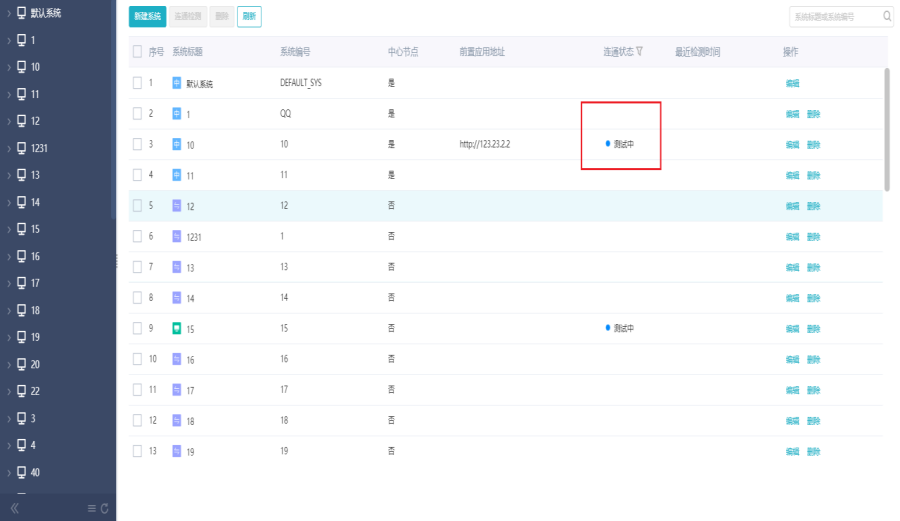

2)连通检测

用户点击进入“连接池管理”、“文件传输代理”、“FTP服务器”、“HDFS数据源”、“Kafka数据源”界面。勾选或全选需要检测的数据源,点击连通检测,检测完成后界面给出清晰提示,包括检测时间,可连通个数,不可连通个数。支持下载日志。

3)下载日志

用户点击下载日志,可对检测日志进行下载查看。

4)自动检测

连通检测后,用户点击“点击前往”。可以设置自动检测功能,每隔一段时间对数据源连通性进行自动检测,时间可以自定义。

10.应用数据源

当在数据资产下新建数据产品时,有时会需要用到应用数据源

目前应用数据源只支持abi5.2.5及以上版本

1)点击添加,输入参数

2)点击测试,提示测试成功后点击确定

请先登录